28日,一起利用AI恶意P图的事件引发人们关注。一名年轻女子在地铁上的照片证实被人使用了AI技术“一键脱衣”。事件源头要追溯到3月初,3月8日,网上开始传播一张看起来像是微信群聊的聊天记录截图,截图中的用户称“我朋友说三号线有个美女把衣服脱了。”并将图片发布在了群中,随后谣言传的越来越离谱,变成了不堪入目的“黄谣”。

记者经过平台搜索找到了图片的源头,发布该图片的是一位小红书博主,本来是一条分享日常生活的内容,原图并没有不适宜传播的地方。3月9日,有不少网友开始向这位博主反馈,说自己在网上看到了恶意P图的博主的照片,从留言用户的IP来看,其传播范围已经远远不止广州一地了,而造谣源头的那个所谓的微信群聊,也并不知到底是哪里首次发布出来的。

博主在9日回应了事件,表示会进行相关的维权处理。一张普通的照片被拿去“造黄谣”,这样的事情不是第一次发生,在该博主的评论区中还有其他女性用户分享类似的遭遇,她表示“气到我头晕……完完全全是感同身受的程度。”而令更多网友感到不安的是,“AI犯罪要来了吗?”“这样的技术,要毁掉一个人的名誉岂不是易如反掌?”深度伪造技术制造的谣言源头加上互联网的快速传播无疑是加重了普通人的维权成本。

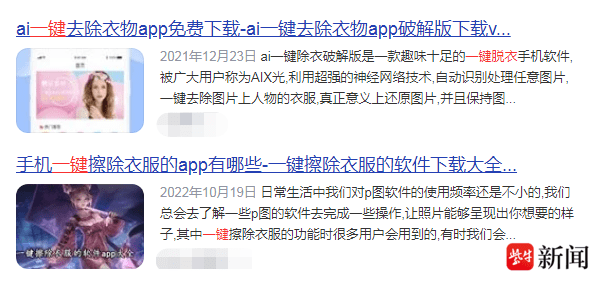

在AI技术萌芽发展之初,深度合成、伪造功能就被心怀不轨的人盯上了。2020年,海外曾发布过一款名为deepnude的软件,该软件就可以通过AI技术实现“一键脱衣”,该软件带来的伦理问题很快引发了争议,很快就被开发商下架了。但是记者发现,国内的网络平台中竟然存在着不少有类似功能的软件,想要下载到一个也并不算困难,还有一些软件是早就被封禁的deepnude的仿版。

类似的事件发生过多次,早些年遭到AI恶意P图换脸的女明星数量甚多,包括了泰勒•斯威夫特、盖尔•加朵等知名艺人,而公众人物的发声和维权都没能完全清除这些AI图带来的负面影响。也因此有网友在质疑,“AI的出现真的是一种进步吗?”AI图像处理技术不管进步到何种程度,说到底也只是一种工具,工具本身并没有好与坏之分,就像刀子能用于料理美味的食物,也能被用做犯罪工具,一个工具好坏色彩是由使用者赋予的。AI图像处理技术在日新月异的变化下给美术、摄影等诸多行业带来了变革,实现了生产力的跃升,它可以说是一个好的工具,但是在别有用心的人手中,AI图像处理技术则成为满足私欲、伤害他人的另一种工具。

尽管已经有不少网友开始呼吁尽快对AI应用领域进行立法管理,但是实际上面临的问题还是相当艰巨,一张图片如何证实是AI参与制作的,如何取证,如何执行等等问题都还悬而未解。在这样的事件中,尽管网友们几乎一致认为技术无罪,有罪的是造谣者,但这些隐藏在非法网站中的软件,何尝不是推波助澜的恶之手呢?需要处理的,不仅仅是犯罪的人,这些隐藏在网络中的非法软件,也应当被看见。

扬子晚报|紫牛新闻记者 沈昭 谭丁元(实习)

校对 陶善工